Les premières années de l’informatique

Le marché des équipements de traitement de l’information a commencé à évoluer en 1960. J’ai tenté ici d’en retracer l’historique en faisant appel à mes seuls souvenirs. Cet article n’est donc pas le résultat d’une étude exhaustive ; il peut aussi comporter quelques inexactitudes. Merci aux lecteurs de les rectifier.

Jusqu’en 1960, les calculateurs électroniques vendus par IBM n’avaient que des programmes câblés, des programmes qu’il fallait construire à la main sur un tableau électrique. Les Américains avaient nommé cette machine « electronic computer » tandis que les Français lui avaient déjà donné ce nom inventé par le linguiste Jacques Perret : « ordinateur ».

C’est précisément cette année-là que la Compagnie des Machines Bull a révolutionné le marché des ordinateurs en commercialisant le Gamma 60, fruit de trois années d’études. Les programmes n’étaient plus câblés, mais enregistrés sur une mémoire centrale de 96 K. Parmi les nombreuses innovations de cette machine, on peut citer aussi des circuits imprimés équipés de transistors et des mémoires matricielles à tores magnétiques. Les concepteurs du Gamma 60 avaient bien conscience d’être à l’origine d’une nouvelle science, c’est pourquoi ils ont inventé le mot « informatique », tellement courant aujourd’hui.

1960, c’était aussi le premier essai nucléaire français en Algérie. Le général de Gaulle, obsédé par l’indépendance militaire à l’égard des Etats-Unis, négligeait tout ce qui pouvait assurer notre indépendance civile. Il n’a donc pas vu l’importance stratégique du Gamma 60, et il a refusé de donner à la Compagnie des Machines Bull les crédits dont elle avait besoin. La compagnie française est achetée à vil prix par General Electric en 1964, ce qui permet à IBM de s’imposer sur le marché des ordinateurs, notamment avec la série 360, en s’inspirant des percées technologiques de son concurrent, et profitant en outre de fabuleux contrats avec l’armée américaine.

En 1967, le général de Gaulle prend enfin conscience de son erreur et veut la réparer en créant le « Plan Calcul ». Des milliers d’ingénieurs sont embauchés, des milliards de francs sont dépensés, mais il est trop tard. L’industrie informatique française est définitivement morte.

La vie d’un informaticien en 1970

Les principaux « langages de programmation » sont l’assembleur, le Basic, le Fortran et le Cobol. L’assembleur est le plus proche du code binaire, son emploi est difficile, et ceux qui programment en assembleur sont regardés avec respect. Les operating systems sont programmés en assembleur. Le Basic est principalement utilisé pour des applications simples, le Fortran pour des applications scientifiques et le Cobol pour des applications de gestion. Ce dernier a le grand avantage d’être très bien structuré, ce qui n’est pas le cas des premières versions du Fortran.

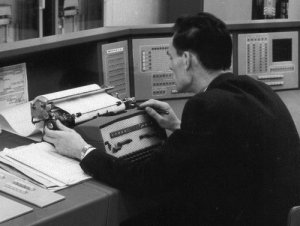

La programmation commence avec un papier et un crayon. Ensuite il faut porter son travail à l’atelier mécanographique où des dizaines d’opératrices perforent des cartes dans un bruit assourdissant. Une carte par ligne de programme. Le lendemain, on va chercher son bac de cartes à la mécano pour le porter au centre de calcul, une grande salle climatisé avec de nombreuses armoires et des imprimantes énormes. C’est là que se fait l’assemblage de votre programme. Le résultat, c’est un gros listing qui souvent annonce des « bugs ». On reprend son papier et son crayon. Il faut généralement plusieurs retours à la mécano, puis au centre de calcul, pour avoir enfin un programme qui tourne correctement.

C’est vers 1978, je crois, grâce aux microprocesseurs 16 bits, que la programmation a pu s’affranchir des cartes perforées. Le temps de mise au point des programmes d’application en a été considérablement raccourci. On pouvait enfin écrire un programme et le déboguer en restant devant son écran. Mais à cette date, j’avais quitté le métier de l’informatique.

76 réactions à cet article

-

Céphale,

Il ne faut pas croire que l’histoire de l’informatique commence avec sa propre histoire.

Cela remonte bien plus haut dans le temps.

Vous en voulez plus c’est ici

Mais c’est vrai, dans la suite de l’histoire qui suit, j’ai dévié vers le côté humain de l’informatique par l’intérieur du business.

-

Bonjour, bon résumé des temps préhistoriques, nostalgie pour les vieux croutons que nous sommes en train de devenir.

Quel enfant de 10 ans pourrait penser que nous allions au palais de la découverte pour jouer au morpion avec une machine qui ressemblait à un frigo flanqué de 2 machines à laver ?

Je ne pense pas que l’on debuggait à l’écran en 1978. On programmait, on lançait des batchs de compilation/link, on lançait des runs. On debuggait éventuellement en truffant le code de « WRITE » pour voir le contenu des variables.

Jusqu’au début des années 1990 j’ai souvenir que l’on sortait des dumps de mémoire centrale (adressage sur 3 octets sur S370) sur listing et que l’on tentait le désassemblage pour voir qui avait écrit dans le code ou pourquoi l’optimiseur avait viré du code !

On se disait « BR 14 » en guise d’adieur ou bien « BALR 14,15 » pour débrancher etc ...

Petite remarque : l’industrie de l’informatique « hardware » est morte - quoique SMT Goupil avait failli la ressuciter - mais le soft ne l’est pas avec quelques fleurons :

- Dassault-Systemes leader mondial de la CAO, du PDM et du calcul

- Business Objects et Ilog qui se placent correctement dans les secteurs du décisionnel et de l’Intelligence Artificielle-

Salut French,

Désolé de contredire, ce qui est dit ici, n’a rien à voir avec la préhistoire.

Cela fait partie d’une histoire déjà en marche depuis longtemps.

Les PC, je dirais même que ce sont de jeunes bécanes.

Vieux croutons ?

Je me suis toujours ressenti comme un dinosaure en fin de course.

Vous savez ce genre de bestiole qui mange plus qu’il ne devrait parce qu’il avait morceau d’expérience dans la chasse.

Je ne sais s’ils mangeaient des croutons, ceux-là. A mon avis, non.

Jouer au morpion avec la bécane, cela n’a jamais été mon truc même à 20 ans.

Avant cela le jeux de morpions, cela se passait sur papier bien loin du numérique.

WRITE au départ, c’était « PUT » qui se conversissait en 6 bytes.

Un code (1) et des adresses avec des bases de registres.

Des USING pour associer tout cela.

Non, je répète, cela n’a rien à voir avec du Basic. -

Bonjour Guy, je parlais de jouer au morpion car c’était ce que l’on pouvait faire au Palais de la Découverte à Paris c’est en bas des Champs-Elysées, un musée qui fut longtemps à la pointe de la techno avant que ne s’ouvre la Cité des Sciences de la Villette. C’est également là que j’ai pu entendre ma voix la premiere fois car il y avait un ... magnétophone public.

Il me semble que ce n’était pas PUT mais FPUT en basic ? Voyez alzheimer me gagne...

Oui oui la préhistoire c’est Internation Business Machine qui dès avant guerre vendait ses trieuses à Mr Hitler pour gérer le fichage des déportés... -

International Business Machines pardon

-

French,

"au morpion car c’était ce que l’on pouvait faire au Palais de la Découverte à Paris c’est en bas des Champs-Elysées, un musée qui fut longtemps à la pointe de la techno avant que ne s’ouvre la Cité des Sciences de la Villette. C’est également là que j’ai pu entendre ma voix la premiere fois car il y avait un ... magnétophone public."Ma première approche avec l’informatique date de 1958 à l’expo universelle de Bruxelles.

IBM avait un pavillon et des machines qui permettait au badaud de recevoir tous les événements qui s’étaient passés lors de sa date de naissance.

Super utile une machine à l’époque, hein ?

Comme quoi, agir sur le subconscient et les petits péchés de l’égocentrisme des gens, cela marche toujours

Il me semble que ce n’était pas PUT mais FPUT en basic ? Voyez alzheimer me gagne...

Oui oui la préhistoire c’est Internation Business Machine qui dès avant guerre vendait ses trieuses à Mr Hitler pour gérer le fichage des déportés... -

J’oublie de répondre. Je ne parlais pas de Basic mais d’Assembler.

-

International Business Machine ?

Chut, entre nous, on appelait cela « Imitation Business Machine »

J’ai dit, entre nous, pas répéter, hein...

-

"Jusqu’au début des années 1990 j’ai souvenir que l’on sortait des dumps de mémoire centrale (adressage sur 3 octets sur S370) sur listing et que l’on tentait le désassemblage pour voir qui avait écrit dans le code ou pourquoi l’optimiseur avait viré du code !"

Le désassemblage je l’ai encore vu faire sur PC bien après l’an 2000 ! C’est (très) rare mais cela sert encore :

- Dans le rare cas ou vous êtes tombés sur un bug du compilo C++. (Dès que vous utilisez des templates les démons de l’enfer peuvent être libérés la plupart des compilateurs ne respectant pas le standard du langage).

- Dans les cas plus fréquent ou vous avez tout codés en C++, qu’après avoir passé un profiler vous avez identifiez la fonction que vous souhaitez optimiser. Et dans ce cas la vous traitez cette fonction au désassembleur pour gagner quelques précieux cycles. (Ce qui n’est pas simple à cause du pipeline).

- Dans quelques cas lié à la sécurité informatique. (Ingénierie inverse, ...).

-

Bonjour Marc,

"Jusqu’au début des années 1990 j’ai souvenir que l’on sortait des dumps de mémoire centrale (adressage sur 3 octets sur S370) sur listing et que l’on tentait le désassemblage pour voir qui avait écrit dans le code ou pourquoi l’optimiseur avait viré du code !"En fait les dumps mémoire sortaient dès la première erreur et l’adresse de l’instruction fautive permettait de remonter la filière jusqu’à l’origine. Enfin, cela pouvait être moins facile que de l’écrire ici.

Les dumps étaient présentés en hexadécimal sur Siemens. -

Merci french_car

Eh bien... vous m’apprenez qu’en 1990 on ne débuggait pas encore à l’écran ! Je n’étais plus là pour le voir. L’accélération du soft a été fantastique dans les années 90. Quelle époque !-

Chez IBM uniquement on débuggait encore comme ça. C’était les dinosaures de l’informatique départementale et des mainframes. French_car apparemment ne connaissait pas encore très bien la micro informatique. Dès 1988 il existait des programmes de tests, des correcteurs de syntaxes et des débuggers divers et variés. Et bien avant ça, depuis des années, sur des machines Unix, on débuggait à l’écran. C’est avec le langage C qu’on a commencé à faire ça proprement. Un petit printf() bien placé, et hop. En 1987 je travaillais sur des serveurs Unix, et on avait pas besoin de décompiler de l’assembleur. Ca, c’était chez mon père, à Honewey Bull. Et encore.

-

Céphale,

« . vous m’apprenez qu’en 1990 on ne débuggait pas encore à l’écran ! »

Faux. On débuggait bien avant les PC sur écran.

Hors les PC, c’était en 1980-1.

Comment croyez-vous que l’on faisait ?

Je vous laisse réfléchir.

-

Bertrand,

"Chez IBM uniquement on débuggait encore comme ça. C’était les dinosaures de l’informatique départementale et des mainframes."

La micro-informatique, je la connais depuis le Cogar sur lequel j’ai simuler l’assembler, le RPG, et le Cobol.

Machine avec des instructions à 1 ou 2 bytes de 8 bits chacun. Le choix de compter en bianire, en hexadecimal ou en octal.

Un MOVE, un IF se faisait par une boucle.

4K de mémoire. Faut dire que chercher à gagner de la place c’était autre chose que du gadget.

Quelle époque en effet. .

. -

Effectivement on pouvait debugger à grand coup d’écritures mais il n’y avait pas de debugger à proprement parler. Pas possible de mettre de point d’arrêt dans la méthode chose de la classe truc pour les djeuns. Et le moyen le plus simple de trouver les raisons d’un plantage était d’avoir un dump de la mémoire sur papier au moment d plantage. Parce que malgré tout se taper 128m de mémoire à l’écran n’était pas pratique. De branch en branch on montait et descendait de qq dizaines de pages. Le fin du fin était de découvrir un beau tableau de réels ou mieux une chaine de caractère au milieu du code, avec un peu de chace on savait désigner le fautif qui avait écrit complètement à côté de la mémoire qui lui était allouée et écrabouillé le code du voisin qui se sentait visé puisque c’était lui qui plantait.

On appelait ça un « cépachémoi » !

Et effectviement ensuite vint UNIX, puis le C, les éditeurs pleine page, puis les debuggers, 100 fois plus efficace mais tellement moins drôle. Il existe encore des fans de vi et dbx pour qui emacs est un gros mot et pour qui Visual n’évoque rien. -

J’ai commencé à développer en 1983 et jusque 1988 je n’ai connu que le S360 (370 ?) sous MVS et TSO.

On n’avait pas un écran par tête de pipe, il fallait préparer son petit bout de papier, faire la queue pour disposer d’un terminal, lancer compil/link/exe, attendre devant la console master de voir quand son job était terminé et demander un petite place pour voir le résultat sans refaire trop la queue ...

A partir de 1988 on a commencé à faire du portage sous UNIX en fait IBM-AIX sur une machine 6150 d’une lenteur déprimante. -

Cogar, s’il ne s’était pas crashé en avion aurait pu devenir le Bill Gates avant l’heure.

Comme quoi, l’informatique ne crée pas la sécurité à cette époque.

-

Une autre histoire des plus comique.

Dans notre petite société, nous avions acheté un 360 d’occasion.

Rien que pour l’installer dans la cave et ensuite planter dans le jardin un pieu dans le sol pour la prise de terre, cela a été un gag. Je m’en souviens encore. -

@french_car

EMACS : Eight Megabytes and Constantly Swapping ! -

Vous vous rappellez mal et faites un gros mélange.

81 : arrivée du Z80. (machine Sinclair ZX81 et ZX Spectrum)

Machines 8 bits. Equipées d’une fonction de translation de plages mémoire redoutable utilisée dans les jeux pour un rafraichissement d’écran immédiat.

83 : arrivée du 8086 et de son co-processeur arithmétique 8088 en 16 bits et instructions longues.

Jusque là, la programmation en language machine était possible et permettait un traitement de l’information bien plus rapide car ne s’occupant pas des IRQ ainsi que d’une gestion graphique lourde.

A partir du 80286, ça a été le bordel. -

Ha oui. Mon premier PC, un AT 286 avec 20 Mo de disque dur, c’était en 1986 je crois. Mais en même temps, j’ai eu mon premier Mac dans les mains, un double-disquettes mega gonflé : 128 Ko de RAM !!! Depuis, j’ai toujours eu des Macs, et de temps en temps un PC pour la forme parce que mon employeur m’en mettait un d’office. Mais même quand je bossais pour Intel (6 ans, jusqu’en 1999), j’étais regardé de travers parce que je ne voulais me servir que de mon Mac portable. Mais y’avait pas photo entre les deux. Depuis, mon meilleur pote qui est resté chez Intel, patron des ventes processeurs Europe du Sud... a fini par craquer pour un Mac portable, et maintenant, il se demande comment il a pu supporter les Winbouzes pendant aussi longtemps. Oui, bon, je sais, ça nous éloigne de l’assembleur et des cartes à trous.

-

Je m’attendais à des réactions de « pro-mac », mais pas suite à mon commentaire.

Le mac est la « rolls » du PC. Soit une machine tournée vers les boeufs qui ne vont considérer que l’aspect graphique (plus des « super-belles-machines-avec-des-coques-qui-tuent » appelées aussi CONviviales et qui coutent une fortune.)

Cela est complètement débile lorsque l’on est assez intelligent pour gérer correctement un PC qui coûte beaucoup moins cher.

Mais bon : il n’y a pas de différence entre une BMW et des hémoroïdes, non.. ?? -

Sans vouloir dire que j’ai la plus longue qui va vous chatouiller les hémoroïdes, en 87, je sortai de l’école, et en 90, je branchai le premier modem sur un AS400 pour relier une agence commerciale.

Certes, quand je vois arriver des jeunes cons qui ne connaissent l’informatique que par les jeux et les « belles » images, cela me fait doucement marrer. -

Dans un Mac, y’a un Unix béton qui ravira tous les adeptes de commandes sudo. Et comme 99% des utilisateurs d’ordinateurs n’y entravent que dalle, il y a surtout un OS convivial, efficace, et qui ne plante pas. Ce n’est pas parce que je peux manipuler des pointeurs dans un tableau en C que je vais perdre mon temps à écrire des bouts de Shell. Ce qui compte, c’est l’usage créatif et productif. La techno pour la techno, c’est de la masturbation.

-

Et j’ai branché des modems et des PADs X25 sur des IBM 6150.

Et j’ai eu des tas d’articles de journaux en 1988 (y compris des généralistes comme Télérama et Libé) pour avoir développé le premier serveur audio-vidéotex en France (en ayant l’idée de piloter un commutateur A/B Philips TRT/TI en frontal d’un modem et d’une carte vocale.

Et j’ai fait les premiers serveurs vocaux interactifs en France en 1989 pour les Caisses d’Epargne, et pour Libération.

Et ça n’empêche que perdre son temps à s’arracher les cheveux sur des dll foireuses et des machines à blue screen cycliques, c’est un non-sens. Moi, j’aime les ordinateurs et les softs qui marchent. Parce que je n’aime pas perdre mon temps. -

Et pour finir, je l’oubliais celle-là, mais c’est celle qui m’a permis de prendre ma retraite anticipée pour faire de la musique (OUI, SUR MAC), je fais partie des 12 mecs qui ont créé fin 99 la boite qui a développé et déployé les softswitchs de VoIP qui contrôlent toute la téléphonie sur IP des Livebox en France. 6 ans plus tard, on était 500. Et tout ça sous des clusters Linux en Load Balancing.

Mais pour faire de la zic sous Linux, faut bien s’accrocher les gamelles au c....

-

Damien vous avez oublié ça : depuis j’ai un peu mal aux chevilles mais je me soigne

-

à plancher

le 8088 n’était pas le n° du coprocesseur mais celui d’un faux 16 bits (2 instructions 8 bits regroupées et traitées ensemble ce qui divisait sa vitesse par 2 .comme le faux 64 d’intel par rapport au 64 d’ amd je pense ? -

Disons qu’en 78 les machines de bureau commençaient à être au point !

Parce qu’en 74 ça existait déjà... Sans être très efficace ! Par exemple la machine ALVAN avec un énorme tambour en guise de disque dur et des dérouleurs de cassettes (modèle « mini-K7 », si, si

mais en plus rapide ) lesquels tombaient régulièrement en panne ! Sachant que le ruban des cassettes s’emmêlait souvent il n’y avait pas intérêt à oublier les sauvegardes !

mais en plus rapide ) lesquels tombaient régulièrement en panne ! Sachant que le ruban des cassettes s’emmêlait souvent il n’y avait pas intérêt à oublier les sauvegardes !Des machines de bureau qui valaient environ 25 000 francs pièce (Le franc de 1974 est presque équivalent à l’euro de 2000) mais vue les problèmes

je pense que ça a dû finir en échec commercial.

je pense que ça a dû finir en échec commercial. -

Bof. Présenter la connexion d’un modem sur un AS400 comme un exploit qui prouve les arguments du Monsieur, ça me fait un peu rigoler, alors je me suis un peu défoulé.

Faites un petit Google sur « Netcentrex », vous verrez si c’est de la fanfaronnade.

Et moi vous me trouverez là par exemple (ça date un peu, 2003) :

http://www.journaldunet.com/itws/it_chauvet.shtml -

Il faut distinguer la micro-informatique et la mini-informatique.

La micro-informatique est apparue vers 1980 avec les premiers microprocesseurs à un prix abordable (par exemple le Z80 de Zilog). Elle s’est développée avec Microsoft d’un côté et Apple de l’autre. C’est une informatique grand public.La mini-informatique est plus ancienne. C’est une extension de l’informatique professionnelle basée sur le système UNIX. Dans les années 80, le leader de la mini-informatique était la DEC (Digital Equipment Corporation).-

Au début des minis (années 70), on ne parlait pas encore d’OS comme on l’entend actuellement, surtout que la capacité des minis ne permettait pas d’héberger un OS aussi gros qu’Unix , chacun se faisait son petit OS, parfois temps réel pour les applications industrielles.

j’ai travaillé sur des mini Digital (pdp8) et Telemecanique (T2000 et solar) puis sur Bull (mini6), mais pas trop longtemps, car déjà les micros commençaient a prendre le pas - je travaillais sur des applis industrielles -

Les PDP étaient (et sont toujours ... il en reste) basés sur un système appelé RSX, un DOS évolué (en fait c’est le DOS qui est tiré de RSX). RSX était écrit en octal.

J’ai travaillé plus de 20 ans sur machines DEC : PDP, VAX, Alphas. -

DEC, absolument. Les minis de l’époque.

Bizarre, que l’on ait oublié les ordinateurs analogiques.

Peut-être réapparaitront-ils plus tard avec la force de calcul. -

En 1988, je travaillais sur un mini sous Unix, avec seulement 1 Mo de RAM et des TTY partout. On était 5 dessus en mode terminal, et ça marchait très bien !

-

moi j’ai commencé en 1975, sur des « mini » grand comme des armoires normandes et contenant des disques de 512koctets (il fallait être 2 pour porte le disque tellement ils étaient lourds et imposants)

par contre le debuggage se faisait aux clés, c’est à dire qu’on pouvait visualiser les contenus des mémoires sur des voyants, et modifier ce contenu à l’aide de clés (la mémoire contenant aussi bien les instructions que les données)

autant dire qu’il fallait connaitre par cœur le code binaire de chaque instruction.

C’était tellement rudimentaire qu’a cette époque quand on démarrait une machine pour la première fois, il fallait rentre le boot (en gros le noyaux du bios actuel), « à la main », c’est a dire entrer aux clés les 15 instructions permettant de lire la bande perforée qui chargeait le programme permettant le lire et installer les autres programmes.A propos de bug, pourquoi quand on répare un programme on dit qu’on le « debug » ?. Cela vient de l’époque des premiers ordinateurs à lampes, ou les programmes s’arrêtaient, parce que des insectes venaient dans l’ordinateur et provoquaient des court-circuits, alors on enlevait ces insectes (bug en anglais« , donc on »dé..bugguait" le programme

-

excellente vaccination de rappel ! félicitations ! Chez Siemens, en bas des trieuses à carte il y avait une.... manivelle : quand il n’y avait plus de courant, on l’activait pour faire... dynamo : c’est bien ça le cap entre mécanique et électronique !!

-

De Gaulle n’a pas fait que cette erreur : les semi-conducteurs (aujourd’hui STMicroelectronics est le seul survivant et encore grâce aux Italiens !) et tant d’autres technologies...

Ses successeurs non plus n’ont pas été brillants c’est un doux euphémisme et l’actuel président détient le ruban bleu de l’incompétence économique : il ne sait même pas que les chevaux se battent à l’écurie quand il n’y a pas assez de foin, mais la sagesse paysanne...il s’en fout !p.s. Et le Micral !!!

-

les responsables de l’échec de l’informatique (hard) française, sont, certes DeGaulle, mais surtout les technocrates qui ont lancé les plans « 100 000 micros pour l’école » qui au lieu de proposer d’etre une locomotive a l’industrie française, en ont ete les fossoyeurs en cherchant a avoir des micros au prix le plus bas possible, tout en exigeant le même service que les autres clients, et du coup, ils ont poussé la plus part des sociétés choisies au dépôt de bilan.

-

hélas : 100 000 microdaubes !

-

1978 ou après, à cette époque là j’ai connu quelques jeunes filles perforatrice-vérificatrice qui travaillait sur ces fameuses cartes perforées !

-

-

tchoo

Ce serait amusant d’avoir le témoignage de ces vieilles dames ! -

Comme l’Enfoiré (coucou Guy !) le sait, j’ai écrit une histoire de l’informatique ... et elle remonte beaucoup plus loin dans le temps.

Pour moi le premier ordinateur est la « machine analytique » de Charles Babbage en 1847., programmé par Ada Byron, qui a pratiquement tout inventé : boucles, sous-programmes ...

Les premiers « calculateurs électoniques » datent des années 1940 : Le « Mark-1 » de Manchester, l’ASCC ou Mark-1 de Harvard et les Z3 et Z4 de Konrad Zuse.

Les premiers ordinateurs ne comprenaient que le binaire et, dès le mark-1 de Manchester, ce qui donnera l’Assembleur (en 1941).

En 1954 IBM sort l’ IBM-650 qui sera vendu à 1500 exemplaires

En 1957 le TX0 est programmé au clavier et stylo optique, sorties écran et imprimante.

Toujours en 1957 est inventé le premier langage évolué : le FORTRAN (FORmula TRANslator).

Un premier langage « universel » est créé en 1958 : l’ALGOL.

Le PDP-1 date de 1959. C’est sur cette machine qu’est conçu le premier jeu : Spacewar en 1960.

C’est en 1960 qu’est inventé le COBOL (COmmon Business Oriented Language sur spécifications de 1958).

Les premiers micro-ordinateurs datent des années 70, au début il faut les construire soi-même à l’aide de plans diffusés dans des revues spécialisées.

UNIX n’est inventé qu’en 1972.

L’Apple II, premier micro à grande diffusion sort en 1977.-

Salut Finael,

Oui, je connais cette histoire. On peut aussi remonté de Blaise Pascal.

Chez les Chinois, le boulier compteur et ils excellaient en rapidité.

Mais il faut se limiter dans le temps et savoir ce qu’on peut estimer faire partie de l’informatique.

Comme je le disais il ne faut pas limiter l’informatique à sa propre histoire.

La roue tourne depuis longtemps.

-

Le premier microprocesseur vendu dans le public, le Z80, sort en juillet 1976.

-

non , le 4004 d’Intel aux env de 1974. Ensuite le 8008 premier 8 bits .vieux souvenirs

-

-

Vous avez eu un parcours qui ne vous a pas permis d’apprécier le développement de l’informatique, comme les commentateurs précédents. Je pense avoir connu les vrais débuts.

En 1969, je travaillais sur deux projets : l’un la « direction lance torpille » du Redoutable, premier sous-marin atomique, l’autre sur le système d’arme Crotale, lanceur de missile sur avions à basse altitude.

Je serais bref : le cœur de ces deux systèmes, était un calculateur, certes pas très rapide en comparaison avec les engins actuels, mais parfaitement apte à faire tourner des logiciels assez complexes. Ce calculateur ne possédait pas de microprocesseur intégré, mais une carte équivalente à mots de 24 bits (le nombre de bits élevé pour l’époque compensait sa toute relative lenteur...) réalisée en circuits intégrés DTuL, la TTL n’apparaîtra qu’en 1970.Sachez que lors d’entretien d’embauche, j’ai souvent montré une des cartes du calculateur en demandant au candidat de la dater : 20 ans plus tard, elle semblait toujours actuelle... (il faut dire q’une carte d’environ 2 dm2 avec un connecteur de 160 points, 2 fois 10 couches, 120 circuits intégrés...

Je me tiens à votre disposition si vous désirez plus de précisions. En tout cas, je peux dire qu’en 2009, j’ai fêté mes 40 ans d’informatique, car les outils que j’utilisais pour les développement comportaient déjà en 1969, claviers, écrans, imprimantes etc.

-

Loule

C’était un 1010 de la CII ? J’ai connu le chef de projet. -

Non, CII avait proposé un calculateur (le 1010 peut-être, il ne m’en souvient plus, mais je ne crois pas, ce nom est trop proche des noms de TIV), mais le calculateur choisi était celui créé par la société qui réalisait les système d’armes :TIV, Thomson Informatique et Visualisation, qui deviendra 2 ans plus tard TVT, Thomson Visualisation et traitement de l’information.

Le calculateur s’appelait TIV 1050, et était aux normes militaires : il me souvient d’avoir fait les essais de fonctionnement entre -30 °C et + 70 °C... ce que CII ne faisait pas (CII n’avouait pas à l’époque, être nulle en calculateurs dits « temps réel », c’est à dire supportant une quinzaine de niveaux d’interruption...)

CII ne proposera que quelques années plus tard un calculateur qui sera accepté (son nom de code de l’époque était Q0M).

Personnellement j’ai quitté la société TVT en 1973 pour m’occuper de traitement de l’information dans les matériels moteurs des chemins de fer, et en particulier des TGV. -

Il aurait fallu remonter à la guerre et aux premiers calculs pour la bombe atomique, l’ENIAC et pourquoi pas la pascaline ...

-

bonjour cephale

content d’avoir lu ton article, trop nul dans ce domaine pour faire un commentaire dessus. ou peut-être les hiéroglyphes ils n’étaient pas sur des écrans de pierre oui un peu vaseux !

cordialement.

-

Merci Céphale pour cet aparté histiro-informatique,

J’ai bien connu cette époque, 23 ans en 70. Et un jour, nostalgie oblige, je me suis dit qu’il fallait raconter un peu cette aventure.

Ce que vous dites (les compiles, l’assembleur, les dump, LE 360, tout est raconté sous une forme humoristique mais très réelle dans un livre « électronique » intitulé « Mes années 360 »

Si cela vous tente, ainsi qu’aux illustres anciens qui vous lisent, alors :

Pour les puristes, le lexique retrace toute cette mouvance technique.

Voir aussi les belles photos des monstres de notre jeunesse !HL

-

Henri

Merci pour le lien. J’ai téléchargé « les saisons » et je vais les lire avec grand plaisir. Dommage que vous n’ayez pas trouvé un éditeur. -

Oui Céphale, j’y avait pensé, mais c’était plus pour le plaisir de retracer mes débuts dans la vie active par rapport aux jeunes d’aujourd’hui, souvent très diplômés, qui galèrent pour le premier job !. Mais je suis surpris car mon site est très visité.

HL

-

J’ai bossé chez IBM Boulogne billancourt dans les années 70. Enormes becanes dans des salles climatisées qui moulinaient en permanence et débitaient sur cartes perforées. Là où j’étais il y avait un département formation et les ouvrages OS, Cobol, Fortran étaient tous en anglais, des gros pavés écrits serrés qui me paraissaient totalement indigestes, de quoi faire des complexes, à voir ces grosses têtes qui s’enfilaient ces gros morceaux avec courage, comme si ça allait de soi.

-

tain moi j ai commence en 1997 sur un.... Bon ok je sors.

-

Salut,

Depuis lors, vous vous êtes appelé faxtronic pour ne pas confondre.

-

Salut, Céphale.

Merci pour ce coup d’oeil dans le rétro. Personnellement, j’ai commencé sur un IBM 365 avant de passer à la série 6000 de BULL.

Les cartes perforées, quel souvenir ! Notamment quand on fichait en l’air un bac de plusieurs centaines de cartes. Bonjour la galère.

Et question galère, que dire des perfos ? Dans la boite où je bossais alors, le couloir qui menait à leur grand bureau paysage etait nommé « rue des Filles du Calvaire » ! Même à 10’ de pause par heure, c’était l’enfer pour elles. Pas trop lorsqu’elles perforaient des programmes de Cobol ou de Fortran, la majorité des instructions étant écrites en anglais, mais surtout lorsqu’elles perforaient des jeux d’essai, faits pour l’essentiel d’incompréhensible séries de caractères alphanumériques...

Quant à moi, de longues années après, il m’arrive de rêver de « Working storage section » pour dire le degré d’aliénation. Ou de revoir les pupitreurs à la tâche gérer la multiprogrammation lorsqu’elle a été mise en place. Jusqu’au moment où survenait un conflit et où le pupitreur devait « tuer » une tache en cours d’exécution pour éviter un plantage général. Bonjour les dégâts lorsqu’il s’agissait de taches durant plusieurs heures. Et bonjour la gueule lorsqu’en en revenant au bureau le lendemain matin on trouvait un listing épais marqué d’un gros « Kill » au feutre rouge. Marrant aussi les gros listings de « dump » (vidage mémoire) qui accompagnaient les jobs plantés et qui nous transformaient en Sherlock Holmes pour dénicher où se situait la « fatal error » !-

Aller encore un peu de courage Fergus :

Nos plus belles années ... en somme !

Henri

-

L’informatique a commençée bien avant les années citées.

L’informatique est la science de l’information et elle n’a rien à voir avec les ordinateur. Comme le disait si bien Dijkstra :

« Computer science is no more about computers than astronomy is about telescopes. »Si l’ordinateur est l’outil qui a fait exploser l’informatique, la gestion de l’information fait partie des préoccupations humaines depuis la nuit des temps :

- Euclide lorsqu’il a crée son « algorithme » pour faire des divisions étaient déja d’une certaine façon un informaticien.

- Les imprimeurs, conscient que le livre offrait « trop » d’information, ont inventé les systèmes de paginations, les indexes, les chapitres. Toutes choses qui n’existaient pas forcément avant Gutemberg. Mais avec l’explosion d’information induite par Gutemberg, il a fallu créer un système pour s’y retrouver.

- La plupart des administrations ont développées des bureaucraties avant l’informatique. Elles stockaient des informations et fesaient en sorte de les retrouver par divers moyens plus ou moins sophistiqués.

- L’invention de machines industrielles comme le métier à tisser de Jacquard était déja une tentative de rendre nos machineries « programmables ». Même si elle était très limitée.

Si Alan Turing et sa fameuse « machine » peut être considéré comme un grand inventeur, il l’a inventé en cherchant à résoudre un tout autre problème et une machine de turing était avant tout un outil « théorique ». Mais lorsque ses travaux ont rencontrés ceux de Von Neumann, l’ordinateur « moderne » était né.

Mais la rencontre entre ces deux génies ne doit pas faire oublier que la société IBM existait depuis déja de nombreuses années et qu’elle fournissait déja de la machinerie pour automatiser le traitement de l’information (et notamment les recensements). Il existait de ce fait un besoin et de nombreux ingénieurs travaillaient à le satisfaire. Et ils y travaillaient depuis longtemps déja comme en témoignent la machine de Babbage, ou les travaux d’Ada Byron. Mais c’est effectivement ce besoin qui devenait de plus en plus pressant qui a aidée les progrès. Et qui a fait que les travaux de Turing ont été compris dans le sens dans lequel ils ont été compris. Si Turing avait fait ces travaux 200 ans plus tot, probablement que ses contemporains ne lui auraient pas vu la même « valeur ».

L’invention de l’ordinateur offrira toutefois un fabuleux terrain d’expérimentation qui va révolutionner l’informatique et la transformer en science. (Science qui n’en est qu’a ses balbutiement). Le défrichage de la théorie des langages, la théorie des graphes et celles des automates, la création des premiers systèmes d’exploitations (et des concepts théoriques qui vont avec) sont probablement beaucoup plus significatifs que le simple aspect « matériel » si c’est l’informatique en tant que telle qui nous intéresse.

L’invention de l’ordinateur a de ce point de vue libéré le diable de sa boite. Et ce n’est pas fini. Pour l’instant, les informaticiens sont dans une course à la complexité ou chaque progrès est réinvesti pour permettre la création d’applications de plus en plus complexes et rendre cette complexité « gérable ».

La création d’applications distribuées reste un sujet de recherche et il nous manque des outils théoriques pour appréhender facilement la création de telles applications. Car c’est bien beau d’avoir du « cloud computing », mais si on ne peut pas écrire des applications l’exploitant à fond, cela ne sert à rien. Mais tellement d’énergie est investie la dedans que cela va venir. Des progrès comme l’algorithme Map-Reduce de Google ont déja été accomplis. D’autres vont suivre. Lorsque cet obstacle sera réglé, vous verrez alors apparaitre une nouvelle génération d’applications informatique.

-

Et c’est pour cela que les anglo saxons disent Information Technology. Notre néologisme « informatique » est joli, mais qui pense à la racine « informa » en le lisant ?

-

Ayant passé pas mal de temps dans une université américaine en tant qu’enseignant, je peux vous affirmer que je n’ai jamais entendu le terme « information technology ». la traduction du mot « informatique » est « computer science ». Mais les Américains sont trop fiers pour adopter un mot français.

-

Bin le super-ensemble de tout ça, c’est les Technologies de l’Information, les ordinateurs en faisant partie.

-

Et je m’excuse Céphale, mais dans mon expérience professionnelle, on emploie IT depuis pas mal d’années. Le terme s’est généralisé à partir de la fin des années 80.

Computer Sciences n’inclue pas la dimension logicielle comme le fait Information Technology. En même temps, l’acception du terme est maintenant plus large que informatique, puisqu’elle englobe aussi les télécommunications, mais comme l’explique bien l’article de wikipedia, IT est un terme qui a évolué pour englober tout ça. -

Croyez-moi : « Computer Science » comprend aussi bien le hardware que le software. Les Américains qui passent un MS en Computer Science connaissent l’un comme l’autre. Encore une fois c’est la traduction exacte du mot « informatique ».

-

Bin non je ne vous crois pas :

Wikipédia :

L´informatique - contraction d´information et automatique - est le domaine d’activité scientifique, technique et industriel en rapport avec le traitement automatique de l’information par des machines telles que les ordinateurs, les consoles de jeux, les robots, etc.

Bref, Information Technology.L’informatique, c’est beaucoup plus large que Computer Sciences si vous lisez cette définition. C’est pourquoi aujourd’hui, à ce que j’en ai vu ces 15 dernières années, on n’utilise que le terme Information Technology (moi, dans l’industrie informatique, je n’ai quasiment jamais rencontré Computer Sciences, et je n’ai jamais vu un groupe industriel informatique se définir comme ça, mais dans leur company profiles et jusque dans leur publicité, c’est Information Technology).

Wikipedia US

Information technology (IT), as defined by the Information Technology Association of America (ITAA), is "the study, design, development, implementation, support or management of computer-based information systems, particularly software applications and computer hardware. -

Céphale,

« . la traduction du mot »informatique« est »computer science« . Mais les Américains sont trop fiers pour adopter un mot français. »

« L´informatique - contraction d´information et automatique - est le domaine d’activité scientifique, technique et industriel en rapport avec le traitement automatique de l’information par des machines telles que les ordinateurs, les consoles de jeux, les robots, etc. »

IT est le diminutif d’Information Technology.

Computer science or computing science (sometimes abbreviated CS) is the study of the theoretical foundations of information and computation, and of practical techniques for their implementation and application in computer systems.

Donc, une question de langue. Quoique même les Américains ont très vite adopté IT pour définir leurs services internes.

Il faut savoir qu’il y a une société qui a pris le nom de Computer Science dès 1959.

-

L’enfoiré

Je dis ce que je sais, et pas ce que je lis sur Wikipedia.Avant de prendre ma retraite, il y a dix ans, je donnais des cours de management dans une grande université américaine (qui a eu des Prix Nobel). Je sais que les cours d’informatique avaient pour titre « Computer Science ». J’ai même gardé des polycopiés. Si des gens préfèrent « Information Technology » ce n’est pas mon problème. -

Cephale,

« Je dis ce que je sais, et pas ce que je lis sur Wikipedia. »

Mais moi, aussi. Moi, cela faisait près de 40 ans que j’ai travaillé dans la branche en tant que « développer ». Dès 1973, chez Univac en outside help d’abord, en 1978, pour m’y fixer. Vous connaissez l’histoire. Que les cours d’informatique s’appellent « x » et que les constructeurs l’appelle « y » n’est pas une discussion très intéressante, à mon avis. Je répondais au sujet de ce que j’ai connu, c’est tout.

C’est pas l’étiquette qui reste, c’est le contenu que l’on utilise.

-

Merci pour cet article.

J’en profite pour citer un des grands acteurs de l’histoire de l’informatique à la française voire au delà, il nous a quitté récemment :

-

C’est vrai les anciens commencent à partir.

A cette époque des débuts, il faut dire que tous les informaticiens se connaissaient ou avaient entendu parler des autres.

Faut-il en avoir une nostalgie ?

Pour moi, non. Le temps ne s’arrête jamais dans ce genre de domaine.

Comme je l’ai écrit dans mon histoire, au début des 80, il y avait quelques livres qui sortaient et qui avaient un titre comme « Que faire avec un ordinateur pour un particulier ? »

Personne ne se pose plus la question.

Alea jacta est...

-

Pour le plaisir, je viens de vous faire une petite page html pour vous montrer comment dans les années 50 les scientifiques voyaient le « Home Computer » des années 2004.

Ça vaut vraiment le détour !

Et le plus drôle, c’est le commentaire (en anglais) !

En résumé : les technos qui permettraient d’arriver à ce monstre ne sont pas encore inventées, il ne sera économiquement pas viable, mais il serait facile à utiliser grâce au télétype et au langage Fortran (quand je regarde mon Mac, je me dis que je l’ai échappé belle)-

Bertrand,

Très belle photo. Très beau commentaire.

Oui, on l’a échappé belle.

La futurologie, une science très aléatoire.

J’ajoute le lien sur ma propre saga.

-

Cette photo nous apprend à rester humble en matière de prédictions !!!

Ok pour le lien, je vais laisser la page en ligne, pas de pb

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

Ajouter une réaction

Pour réagir, identifiez-vous avec votre login / mot de passe, en haut à droite de cette page

Si vous n'avez pas de login / mot de passe, vous devez vous inscrire ici.

FAIRE UN DON

mais en plus rapide ) lesquels tombaient régulièrement en panne ! Sachant que le ruban des cassettes s’emmêlait souvent il n’y avait pas intérêt à oublier les sauvegardes !

mais en plus rapide ) lesquels tombaient régulièrement en panne ! Sachant que le ruban des cassettes s’emmêlait souvent il n’y avait pas intérêt à oublier les sauvegardes ! je pense que ça a dû finir en échec commercial.

je pense que ça a dû finir en échec commercial.