Les neurosciences, la grande illusion en éducation

La crédibilité des neurosciences n’est pas assurée sur le plan de l’éducation, les preuves de leur efficacité sont souvent fragiles ou même absentes. Les arguments avancés reposent sur des études rarement corroborées sur le terrain et comportant nombre de biais conceptuels et méthodologiques.

L’école, au sens large, est soumise en permanence à des modes, la dernière est les « neurosciences »... D’éminents chercheurs qui font des recherches sur les mécanismes neurobiologiques qui sous-tendent la cognition (perception, motricité, langage, mémoire, raisonnement, émotions...) dictent comment on doit apprendre et par là les conditions de l’enseignement. Imbus de leur science qu’ils n’interrogent pas sur le plan épistémologique et fiers de leurs belles machines qui sont censées fonder leur scientificité, ils présentent leurs propos non pas comme des hypothèses pédagogiques qu’ils tenteraient en « bons scientifiques » de corroborer sur le terrain avec des élèves. Non ! elles sont les nouvelles vérités pédagogiques sorties directement des… IRMf[1] ! L’école demanderait-elle moins de sérieux que les sciences ?..

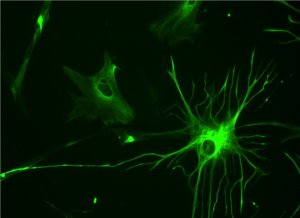

Les médias, toujours avides de sensationnel[2], leur emboitent automatiquement le pas, sans jouer leur rôle critique. Le « tam-tam » est lancé… Le grand public, fasciné par tout ce qui touche au cerveau, ne peut qu’être réceptif. Il en devient même enthousiaste quand on lui présente doctement les surprenantes photos « du cerveau » supposé en action. Le discours prétendument « scientifique » de la démarche légitime les idées avancées ; peu importe, s’il ne s’informe pas ni sur les couleurs virtuelles proposées, ni sur les méthodologies qui les ont permises. Dès lors, l’enthousiasme pour la neuroimagerie, gagne les décideurs politiques. Des sommes considérables sont investies dans différents projets. Plus d'un milliard d'euro est alloué à l’Human Brain Project, par la Commission européenne, la BRAIN Initiative que vient de lancer Barack Obama aux USA a reçu lui un budget de 100 millions de dollars.

Avec cette frénésie médiaco-politique, nombre d’enseignants disent de plus en plus fréquemment s’inspirer du fonctionnement du cerveau dans leur pratique pédagogique. La Brain Gym[3], la gymnastique du cerveau et la brain-based learning[4] –l’apprentissage basé sur le fonctionnement du cerveau- font de nouveaux adeptes en Europe[5]. Des séminaires, des programmes de formation neuropédagogiques sont mis en place, approuvés par des fédérations de parents d’élèves.

Une crédibilité non assurée

Pourtant la crédibilité des neurosciences n’est pas assurée sur le plan de l’éducation, les preuves de leur efficacité sont souvent fragiles ou même absentes. Les arguments avancés reposent sur des études rarement corroborées sur le terrain et comportant nombre de biais conceptuels et méthodologiques. Le cas le plus typique de ces dernières années furent les écrits et les dires de Stanislas Dehaene, Professeur au Collège de France, chaire de psychologie cognitive expérimentale. Suite à ses études sur la lecture et le cerveau, ce chercheur s’est permis d’avancer des considérations pédagogiques sans appel :

« On comprend notamment pourquoi la « méthode globale » d’apprentissage de la lecture est condamnée à ne pas bien fonctionner. En effet cette dernière attend de l’enfant qu’il reconnaisse un mot entier – « chaise », « vache », « lapin » – et non ses composantes autonomes, associations de graphèmes et de phonèmes, que l’enfant devra décomposer en lettres et en sons. Or ce sont bien sur ces segments, à commencer par les lettres, que travaille le cerveau, quand il mobilise ses algorithmes de reconnaissance des visages. Le « b a ba » dont on s’est tant moqué est ce qui permet le mieux d’activer et de recycler les zones cérébrales adéquates[6]. »

Pour ce chercheur, il suffirait d’attirer « l’attention[7] de l’élève » vers l’aire cérébrale appropriée pour que disparaisse toute difficulté et même soit éludé tout contexte scolaire, social, familial, culturel… Difficile en l’état des recherches de neurobiologie d’avancer « une aire de la lecture », cela serait en plus en contradiction avec les autres travaux sur le fonctionnement du cerveau qui se concentrent sur des réseaux neuroniques !

La médiation télévisée de son étude l’entraine vers des directives encore plus directes : « ceux qui ont une méthode alphabétique, phonique entraîne le circuit de l’hémisphère gauche qui est le circuit universel, efficace de la lecture. Les personnes qui ont une attention globale, la forme du mot, ces personnes n'utilisent pas ce circuit. Leur attention est orientée vers l’hémisphère droit qui est un circuit beaucoup moins efficace pour l'analyse de la lecture ». Pour lui, « tout autre circuit d'apprentissage éloigne l'enfant de la lecture »"[8].

Pourtant, la variable « méthode » prise en compte est trop grossière et mal définie. Comment la considérer comme un paramètre pertinent pour une véritable recherche ? Difficile de définir avec précision et pour de nombreux enseignants une méthode spécifique. Il faudrait également qu’une méthode globale existât sensus stricto[9]… Et pour les enseignants qui envisagent une méthode semi-globale, encore faudrait-il distinguer les différents paramètres de chacune de leurs démarches. Or il est difficile de repérer des maîtres qui pratiquent de façon uniforme. Chacun introduit des variantes, donc des paramètres différents, non pris en compte dans l’étude qui se veut « scientifique » ci-dessus !

De toute façon, si ce chercheur avait pris le temps de faire la moindre veille pédagogique, il aurait repéré que le débat méthode globale versus méthode syllabique est aujourd’hui largement dépassée de part le monde de l’éducation. Les enfants peuvent apprendre à lire en jouant avec les mots à 4 ans[10]… D’eux-mêmes, leur attention a été attirée par les mots parce qu’ils y ont trouvé du sens, heureusement sans méthode ! Les méthodes ne marchent en réalité que pour ceux qui les créent. Le processus d’apprentissage de la lecture chez chaque enfant est unique, il dépend essentiellement de son désir d’apprendre à lire et du contexte qui le favorise…

Loin de nous, l’idée de dénoncer toute étude du cerveau à des fins d’éducation. Certes on pourrait y voir la résurgence d’un certain « scientisme » et un oubli des visions humaniste et holistique de l’éducation. Au delà de ces limites, leurs apports pourraient être très profitables dans la mesure où ils sont fondées et qu’ils ne prétendent pas plus que l’état du domaine le permet...

Avec le recul que permet l’histoire du domaine, nombre de données des neurosciences de la fin du siècle dernier se sont trouvées réfutées. On peut citer en autres, la non multiplication des neurones, passée un certain âge, la distinction entre le cerveau droit et le cerveau gauche, l’aire spécialisée de la mémoire, etc.. Actuellement il existe un consensus pour dire qu’à tout âge les neurones peuvent se multiplier. On sait également que cerveaux droit et gauche fonctionnent en synergie et le centre de la mémoire n’est au mieux qu’une sorte de « central téléphonique »…

Les limites méthodologiques

Des études neurologiques pourraient être fort utiles pour mieux comprendre les mécanismes de la cognition en général, de l’apprendre en particulier ; elles seraient fort profitables pour mieux structurer les environnements d’apprentissage ou les politiques éducatives, si ces études étaient mieux situées sur le plan méthodologique.

Actuellement, plusieurs principaux biais sur le plan de la problématique et de la méthodologie peuvent être mis en avant qui leur enlèvent toute pertinence. En effet, les méthodes d’investigation en neurosciences se trouvent être des approches indirectes, très fastidieuses à mettre en place et prenant appui sur une technologie très coûteuse. Les échantillons analysés ou comparés demeurent trop limités. Il en résulte déjà un manque de fiabilité statistique qu’il s’agit de dénoncer avant toute extrapolation. « Small, low-powered studies are endemic in neuroscience » déclare une méta-analyse publiée dans Nature Reviews Neuroscience[11]. Ces chercheurs ont en effet passé au crible les méthodologies de 740 articles publiés en 2011 dans le champ.

En France, des neuropsychologues comme Fabrice Guillaume[12] nous alertent sur ces limites. « Le résultat est pour le moins inquiétant : les études examinées présentent une puissance moyenne d’environ 20 % ! Il faut savoir qu’habituellement, la puissance d’un test, c’est-à-dire son aptitude à mettre en évidence une différence lorsqu’elle existe (..), est considérée comme satisfaisante à partir de 80 %. »[13]

De plus, leurs corpus sont fréquemment discutables, notamment dans les études sur les neurodysfonctionnements, car les sujets sont choisis souvent par opportunité, sans critères suffisamment définis au préalable[14].

Déjà quand on regarde de près ces publications, on peut contester certaines approches expérimentales ; elles se trouvent discutables à cause des contraintes techniques, pouvant être ambigües et souvent peu interrogées. Par exemple, il est difficile de comparer une situation d’interrogation cognitive sous IRMf et une situation de classe ! Il n’est que de regarder la position du sujet lors de l’expérimentation ou les situations de compréhension, on est très loin des situations de formation.

Les catégories envisagées restent dans le flou, notamment quand on compare des méthodes comme on vient de le voir précédemment dont les contours sont mal définis ou quand on met en avant des compétences comme « l’attention » ou la « motivation » dont les caractéristiques varient d’un auteur à l’autre.

Il est anormal que contrairement aux autres domaines scientifiques, les Comités de lectures des revues de références soient si peu exigeants. Ces négligences méthodologiques font peser un doute légitime sur la fiabilité des résultats.

Enfin, l’autre « gros » problème méthodologique résulte des neuroimages, elles-mêmes. Celles-ci sont produites grâce une grande variété de techniques, basées sur des principes différents. La plus ancienne est l’électroencéphalographie (EEG), mise au point en 1929, par le neurologue Hans Berger. Depuis, ont été développées l'imagerie par résonance magnétique fonctionnelle (IRMf), la tomographie par émission de positrons (TEP), la magnétoencéphalographie (MEG), l'Imagerie spectroscopique proche infrarouge et la mesure du signal optique évoqué. Suivant le type d’études, ce que l’on veut mettre en évidence ou/et les moyens du laboratoire, une des méthodes est privilégiée.

Il est important de comprendre que chaque fois les images obtenues ne sont jamais une image directe de l’activité du cerveau, mais une image reconstruité. Par exemple, l’IRMf repère l'afflux de sang oxygéné dans les différentes zones du cerveau ; celui-ci varie en fonction des situations présentées. Par cette approche, le chercheur suppose repérer les régions du cerveau spécialement actives lors d'une tâche donnée. De même, la TEP mesure les modifications du débit sanguin au moyen d'un traceur radioactif préalablement injecté par voie intraveineuse.

L’image finale présentée dans les articles scientifiques, et souvent reprise par les médias, est ainsi une modélisation ; elle peut même intégrer des résultats statistiques. Dès lors, les paramètres de cette reconstruction, notamment le choix des « fausses couleurs » employées, surdéterminent à la fois l’image obtenue et l’interprétation proposée.

L’image se veut parler d’elle-même, elle fascine tout à la fois ses auteurs et le grand public. Elle exerce néanmoins par son apparente simplicité, et par son attractivité où interviennent de « jolies » couleurs, parfois même des animations,.., une force de conviction intrinsèque. Son pouvoir de séduction en fait une supposée preuve. Elle finit par devenir une réalité objective, difficile à contester. On en oublie les artéfacts mis en place pour obtenir le résultat attendu !

Les dangers de ce type spécifique d’induction sont multiples. Les interrogations sont variées : que signifie réellement ces corrélations entre circulation du sang, dépense d’énergie et processus psychologiques, surtout que ces derniers restent encore largement inconnus ? De plus, connaître les supports cérébraux d’un processus cognitif ne revient pas automatiquement à l’expliquer. Or à partir de l’observation d’une activation dans une « région » du cerveau, les auteurs en déduisent rapidement –trop rapidement- la présence d’une activité psychologique et mentale particulière…

Cela pose également une question épistémologique sur laquelle nous reviendrons dans le point suivant. Localiser une région cérébrale, la mettre en lien avec un processus ou un comportement n’est valide que si cette région est unique. Or la plupart des zones de notre encéphale ne sont pas spécifiquement dédiées à une seule activité cognitive.

Des neuroscientifiques eux-mêmes, mais ayant moins de visibilté médiatique, dénoncent ce manque de rigueur scientifique, conduisant à des « « résultats anormalement optimistes »[15].

Limites épistémologiques

Un domaine aussi complexe que celui du cerveau et de la cognition demande qu’on s’interroge également et plus largement sur son contexte et sur ses soubassements : concepts en jeu, modèles envisagés et paradigmes sous-jacents et sur l’histoire des idées portant sur le domaine d’investigation. L’approche épistémologique, avec son volet historique, est incontournable ; elle devrait porter au minimum sur 3 aspects incontournables.

Pour comprendre le cerveau et son fonctionnement, il fallut d’abord dépasser les considérations religieuses ; celles-ci condamnaient l’idée que l’esprit put avoir un ancrage matériel. Ces circonspections retardèrent pendant des siècles toute approche sérieuse de la cognition. Cet obstacle dépassé, un débat virulent se mit en place entre les partisans d’un fonctionnement holiste du cerveau et les phrénologistes, partisans d’une théorie selon laquelle les bosses du crâne d'un être humain reflètent son caractère. Au début du XIXème siècle, un anatomiste allemand, exilé en France, Franz Joseph Gall développe une théorie localisationiste ; les facultés mentales sont liées spécifiquement à certaines parties du cerveau qu'il baptisa « crânioscopie » et que l'un de ses disciples, Johann Gaspar Spurzheim rebaptisa « phrénologie » en 1810[16]. Cette ambition de vouloir lier une fonction cérébrale à l’anatomie en fait donc un précurseur des neurosciences cognitives.

Pierre Flourens, en physiologiste rigoureux, critique sévèrement les méthodes des phrénologistes. Alors qu'il parvient à identifier le rôle du cervelet dans la motricité et du bulbe rachidien dans la régulation végétative, il suppose, notamment sur la base d'observations sur les oiseaux, que le cerveau est un organe indifférencié. Il ne peut fonctionner que comme un tout dans la production des activités comportementales et même dans la production de la pensée.

Néanmoins les recherches de Gall auront le plus grands des succès[17] ; elles ouvriront la voie à un ensemble de travaux portant sur les liens entre les aires du cerveau et les facultés mentales. En particulier, Paul Broca, professeur de pathologie chirurgicale à l'Université de Paris, déterminera, suite à des cas cliniques, la localisation cérébrale du langage articulé en 1861. Nombre de corrélations anatomo-cliniques furent alors recherchées.

Ces travaux furent développés par des neurologues ou des psychiatres comme Karl Wernicke, John Harlow, William Osler, sur des patients ayant subi des traumastismes spécifiques. Et en 1913, apparaît le mot « neuropsychologie » pour désigner la science étudiant les relations entre les perturbations cognitives et émotionnelles, ou encore les désordres de la personnalité et les lésions du cerveau. Dans ce cadre, deux « découvertes » importantes seront formulées, dans la première moitié du 20 ème siècle :

- les aires de Brodmann[18]

- les homoncules de Wilder Penfield[19].

Devant ces succès et la place prise par le réductionnisme en sciences, la phrénologie, désormais appelée « localisationnisme » l’emporte largement. Et c’est toujours ce modèle qui est très présent, implicitement, dans les recherches en neurosciences actuelles. Pourtant nombre de données nouvelles réfutent totalement ces paradidmes et relancent le débat localisationnisme-holisme.

1. Certes, l’association d’une région cérébrale propre à chaque faculté et d’une « bosse » correspondante sur la boîte crânienne (dont la célèbre « bosse des maths ») n’est plus de mise. En revanche, la croyance d’une dissociation de la pensée en composants élémentaires correspondant à des compétences spécifiques se maintient chez nombre de neurologistes et de psychoneurologistes. Toutefois la cartographie avancée reste sommaire et surtout épistémologiquement infondée : « la carte n’est pas le territoire ! » Une fonction cérébrale donnée est en général assumée par plusieurs centres connectés entre eux, réalisant des circuits se modifiant au cours du temps. Les activités cognitives sont largement distribuées dans l’ensemble du cerveau par le biais de réseaux de neurones. Chaque tâche, aussi précise soit-elle, est produite par des réseaux de neurones localisés en divers endroits du cerveau. En permanence de nouveaux réseaux peuvent se constituer pour faire face à des lésions ou sous l’influence de l’environnement.

Néanmoins, des publications continuent par habitude ou facilité de mettre directement en relation l’activité du cerveau et une faculté mentale, quand elles n’associent pas en sus une catégorie sociale !.. Une étude par exemple met en relation l’activité cérébrale de personnes de milieux défavorisés à celle observée chez des patients souffrant de lésions localisées dans le lobe frontal[20]. L’activité de l’amygdale est présentée comme le lieu de reconnaissance et d’expression des émotions. Elle est considérée plus importante chez les enfants de milieu défavorisé[21] !

2. Dans nombre de cas, l’approche expérimentale envisagée dans les neurosciences reste classique et dans le cadre d’une logique binaire. On introduit une comparaison de deux populations dont on fait varier un seul paramètre à la fois. Rarement, on traite la complexité du fonctionnement du cerveau de façon systémique. Cette approche expérimentale réduite à deux dimensions est trop frustre, dans la mesure où il est admis que le facteur X n’entraine pas automatiquement l’activité Y. D’autres facteurs V, W et Z –d’origines biologiques, culturelles ou environnementales, etc- peuvent interférer pour amplifier le phénomène ou l’inhiber.

Pour obtenir une plus grande fiabilité, une combinatoire serait nécessaire. Or sur les plans méthodologique et technologique, elle n’est pas aisée à mettre en œuvre. Le plus ennuyeux est que ce mode de raisonnement entretient une vision très finaliste. Les conclusions des articles ont tendance à expliquer que telle structure ou telle molécule sert à telle fonction. Ces conclusions sont reprises dans les médias de façon plus schématique : « la dopamine est la molécule de la récompense », « le cortex préfrontal est la zone de prise de décision » ou l’amygdale est tout à la fois le centre de l’émotion et de… la mémoire, alors qu’il serait préférable de l’envisager comme une « zone d’aiguillage »… D’autres magazine vont jusqu’à formuler l’existence d’« un gène de la maladie d'Alzheimer »[22]. Or, ce qu'on appelle par commodité une « fonction » apparaît plutôt actuellement comme une propriété émergente du vivant qui a été conservée par les mécanismes de l'évolution car elle fournit un avantage aux organismes qui en sont dotés.

3. Le biais épistémologique le plus délicat, car le moins établis, concerne la cognition, et par là de l’apprentissage. Le cerveau n'est pas la pensée, tout comme les gènes ne sont pas l’individu. Sans aucune contestation possible, la pensée, les émotions, les intentions ou le désir ont un support biologique indéniable. Toutefois la pensée d’une part, les émotions d’autre part se situent à un autre niveau de complexité que celui des régions du cerveau, des synapses et des neurotransmetteurs… Il existe une rupture épistémologique entre le « monde » des neurones et celui des idées.

Une activité mentale donnée -par exemple : la motivation- ne résulte pas seulement de l’activité neuronale mais aussi de l’organisation fonctionnelle du cerveau, divisée entre différents circuits et réseaux de neurones synchronisant leurs activités. Elle est une émergence de « cascades » où interviennent certes des éléments génétiques et neuroniques, mais également de façon très active et prépondérante le contexte, l’environnement social et culturel qui ont interagi avec l’individu au cours de son histoire de vie.

La pensée, véhiculée par les mots, les concepts et les émotions, a un support biologique objectif, qui met en jeu également des circuits et des connections neuronales. Cependant l’activité métabolique des différents centres ou des circuits cérébraux est modifiée par les situations vécues par la personne. On a constaté une interaction semblable entre l’environnement et les gènes, ce qui a donné lieu à une nouvelle approche, l’épigénétique. Celle-ci montre comment le contexte peut modifier l’expression des gènes sans modifier leur structure en agissant sur des facteurs de régulation génétique.

Comprendre comment la conscience et les émotions émergent à partir de processus neurochimiques reste encore une énigme. Il y a sûrement une interaction constante entre le psychique et le biologique, sans qu’on puisse les réduire l’un à l’autre. L’enthousiasme de l'imagerie cérébrale à révéler le contenu de nos comportements ou de nos pensées ou à présenter la physiologie cérébrale comme étant le niveau d'explication le plus pertinent n’est pas fondée et peu pertinent pour expliquer les situations qui favorisent l’apprendre. Le neuro-polémiste Raymond Tallis – qui avait lancé en 2011 sa propre offensive contre la vulgarisation neuroscientifique, va plus loin avec ses critiques dans les colonnes de The Observer[23]. Il affirme que les « études qui isolent des phénomènes irréductiblement sociaux (…) dans les fonctions ou les dysfonctions de bouts de nos cerveaux sont conceptuellement fausses ».

Ce qui conduit les neuro-psychologues Evelyne Clément, Fabrice Guillaume, Guy Tiberghien et Bruno Vivicorsi[24] a conclure un article dans le Monde diplomatique ainsi : « (..) le cerveau est le substrat matériel de notre activité mentale, mais il ne pense pas ; seule la personne pense. Et le contenu de ses pensées trouve son origine à l’extérieur du cerveau, dans son environnement interne et externe. L’image ne donne pas à voir des pensées, mais des corrélats biologiques de ce que fait un être humain quand nous disons qu’il pense : activité électrique, variation du flux sanguin, etc. Le cerveau est la condition objective de la réalité mentale, mais c’est cette réalité mentale qui le façonne. Oublier ces deux faits relève de la neuromythologie scientiste. »

Conclusion provisoire

Les neuroscientifiques ne sont toujours pas sortis de leur phase d’enthousiasme ! Ils continuent de baigner dans une douce euphorie : « leurs trente glorieuses » comme ils déclarent ! Nombre de collègues universitaires entrent alors en résonnance, vu les crédits et les postes à portée de main. On ne parle plus de pédagogie, mais de « neuropédagogie », de didactique des maths ou du français, mais de « neurodidactique des maths ou du français » ! Certains vont même jusqu’à vouloir prédire dans le cerveau les potentialités d’un élève, tout comme il y a vingt ans, on voulait découvrir dans les gènes les potentiels physiologiques ou criminogènes d’une personne.

Pourtant l’étendue de notre ignorance reste immense en la matière. Malgré les crédits avancés, il nous faudra au moins 10 à 20 ans pour aller vers quelques certitudes durables. Quelques signes rassurants cependant, de plus en plus de neurobiologistes commencent à en prendre conscience, comme Hervé Chneiweiss au Symposium l’aventure des neurosciences (Angers 2015) qui appelle enfin à la « prudence », tant comme on vient de le voir les résultats avancés manquent de fiabilité et de crédibilité.

Sans doute faut-il dénoncer ici la pratique éditoriale des revues de références en neurosciences, le manque de rigueur et d’exigence de leurs referees. Contrairement aux autres domaines scientifiques, ceux-ci se permettent de laisser passer des articles qui seraient certainement retoqués ailleurs, parce que pas suffisamment fondés sur le plan expérimental. Leur Comité éditorial refusent en sus de publier les études complémentaires qui dupliquent sur une plus grande échelle des données déjà parues ; surtout elles recalent les travaux qui contredisent des études précédentes. Cela entraîne une faible reproductibilité des résultats. Il faudra donc attendre quelques années pour faire le point sur les supposées avancées actuelles.

Ce problème dépend en grande partie des succès de la médiation du domaine et de la fameuse pression mise sur les laboratoires de recherche, en lien avec les crédits engagés. Le « Publish or perish" induit des publications trop rapides, et par manque de recul, insuffisamment argumentées et surtout peu établies.

En l’état, un autre neuroscientifique, Steve Masson, professeur à la Faculté des sciences de l’éducation de l’Université du Québec à Montréal (UQAM), directeur du Laboratoire de recherche en neuroéducation (LRN), directeur en chef de la revue Neuroéducation et Président de l’Association pour la recherche en neuroéducation, un organisme ayant pour mission le développement et la diffusion de la recherche en neuroéducation a essayé de faire honnêtement le point de la question des relations entre cerveau et enseignement dans le cadre d’un Symposium international qui s’est tenu à Anger en 2015[25]. On ne peut pas dire que ses conclusions apportent beaucoup de données pour transformer l’éducation !

Après avoir dénoncé plusieurs « neuromythes », ses propositions se limitent à avancer que l'apprentissage influence le cerveau, en insistant sur la neuroplasticité de cet organe et l’établissement de connexions neuronales. Réciproquement, le fonctionnement du cerveau influence l'apprentissage ; notamment pour lui, « l'activation neuronale répétée améliore l'apprentissage ». De même, l'espacement des séances sur un même thème est nécessaire pour réactiver les neurones et faciliter la compréhension ». Enfin, « l'enseignement influence le fonctionnement du cerveau » : il insiste sur l’importance de « rendre actif le cerveau de l'apprenant autour de la notion à acquérir ».

Comment faire évoluer l’organisation de l’école et les pratiques d’apprentissage avec si peu de données confirmées, qui de plus ne sont pas nouvelles !.. Quand on sait, à travers les études concernant l’Evolution, que le cerveau recycle des réseaux neuroniques anciens pour permettre des acquisitions culturelles et si l’on met cela en lien avec la plasticité du cerveau, on peut faire l’hypothèse que ce n’est pas le cerveau qui est actuellement le facteur limitant de l’apprendre, même s’il en est le support. Le contexte social, l’environnement culturel, les conditions de la classe sont largement prépondérants sur le plan scolaire. Les recherches portant sur les situations, les activités, les apports des enseignants et des médias qui favorisent le désir d’apprendre et « nourrissent » l’apprenant devraient plutôt être considérées comme prioritaires par les décideurs.

[1] L’IRMf ou imagerie par résonance magnétique fonctionnelle est une application de l'imagerie par résonance magnétique permettant de visualiser, de manière indirecte, l'activité cérébrale.

[2] Les médias, mais également les revues scientifiques de référence, favorisent les résultats que l’on peut qualifier de "sexy », par rapport aux articles de fond où les auteurs cherchent à vérifier les avancées de leurs collègues, activités pourtant indispensables à la bonne marche de la science.

[3] Dennison, Paul, Switching On : The Whole Brain Answer to Dyslexia, Ventura, CA, Edu-Kinesthetics, Inc., 1981. T f : Kinésiologie, le plaisir d'apprendre, Le Souffle d'Or, Barret-Le-Bas, France, 1988.

Dennison, Paul and Gail Dennison, Edu-K for Kids, Ventura, CA, Edu-Kinesthetics, Inc., 1985. Tf : Kinésiologie pour enfants, Le Souffle d'Or, Barret-Le-Bas, France, 1989.

[4] Caine, R., and G. Caine. Making Connections : Teaching and the Human Brain. Menlo Park, Calif. : Addison-Wesley, 1994.

[5] Ces pratiques déjà anciennes pour lesquelles l’engouement était retombé cherchent à illustrer leurs postulats de base à travers les neurosciences. Il en est de même pour la Gestion mentale, PNL, ARL, etc.)

[6] Stanislas Dehaene, Les quatre piliers de l’apprentissage, ou ce que nous disent les neurosciences, Paristech Review, November 7th, 2013

[7] « Les neurosciences cognitives ont identifié quatre facteurs qui déterminent la facilité d’apprentissage. En premier l’attention… » (Stanislas Dehaene, ibidem). Fallait-il attendre les neurosciences pour mettre en avant cette faculté, d’ailleurs toujours mal définie ! Socrate ne disait-il pas déjà des choses semblables…

[8] S. Dehaene, Interview JT de France 2 mardi 16 septembre 2014. Voir également Dehaene Stanislas, Les neurones de la lecture. Paris : Odile Jacob, 2007. S. Dehaene, Apprendre à lire. Des

sciences cognitives à la salle de classe. Paris : Odile Jacob, 2011. S. Dehaene Stanislas, Que nous apprennent les neurosciences sur les meilleures pratiques pédagogiques ? Regards croisés sur l’économie, vol.n°12, n°2, janvier 2012, p.231-244.

[9] « Ainsi la forme globale des mots n’intervient à aucun moment de la reconnaissance de l’écrit. Les exercices relevant de la méthode globale ou semi-globale n’ont pas lieu d’être car ils attirent l’attention de l’enfant vers le mauvais niveau de traitement – un de nos collègues a montré qu’ils activent la mauvaise région cérébrale, dans l’hémisphère droit ! ». Apprendre au XXIe siècle : interview de Stanislas Dehaene,

http://www.mondeo.fr/index.php?option=com_content&task=view&id=99&Itemid=1

[10] Françoise Boulanger, Le Bonheur d'apprendre à lire, Nathan, 2002. André Giordan, Préface in Boulanger, F., Le bonheur d'apprendre à lire, Accompagner son enfant de 2 À 5 ans, Nathan, 2002. S.E. Mol, S.E. and A.G. Bus (2011). To Read or Not to Read : A Meta-Analysis of Print Exposure From Infancy to Early Adulthood, Psychological Bulletin, 137, 267–296. 2011. Par ailleurs, nombre de petits scandinaves apprennent à lire très jeunes par eux-mêmes grâce aux sous-titres des dessins animés.

[11] Katherine S. Button, John P. A. Ioannidis, Claire Mokrysz, Brian A. Nosek, Jonathan Flint, Emma S. J. Robinson & Marcus R. Munafò, Power failure : why small sample size undermines the reliability of neuroscience, Nature Reviews Neuroscience 14, 365-376 (May 2013)

[12] F. Guillaume, G. Tiberghien et J.-Y. Baudouin, Le cerveau n’est pas ce que vous pensez : Images et mirages du cerveau, Presses Universitaires de Grenoble, 2013.

[13] Le Monde de l’intelligence – N° 32 – septembre/octobre 2013

[14] Nombre d’auteurs dénoncent ces biais : D. Ansari, B. De Smedt et R. Grabner, Neuroeducation - A critical overview of an emerging field, Neuroethics, 2012, vol.5, n°2, août, p.105-117. A. Claeys & J-B Vialatte, L’impact et les enjeux des nouvelles technologies d’exploration et de thérapie du cerveau. Rapport n°476. Paris : Office parlementaire d’évaluation des choix scientifiques et technologiques, 2012. B. De Smedt, D. Ansari, R. Grabner et al., Cognitive neuroscience meets mathematics éducation, Educational Research Review, 2010, vol.5, n°1, p.97-105.

[15] R. Poldrack, The future of fMRI in cognitive neuroscience, NeuroImage, vol.62, n°2, août 2012, p.1216-1220. E. Vul Edward, C. Harris, P. Winkielman & H. Pashler Harold, Puzzlingly high correlations in fMRI studies ofemotion, personality, and social cognition, Perspectives on Psychological Science, vol. 4, n°3, mai 2009, p.274-290. D. A. Turner David, Which part of “two way street” did you not understand ? Redressing the balance of neuroscience and éducation, Educational Research Review, vol.6, n°3, 2011, p.223-231

[16] Cette théorie localise les fonctions cérébrales dans des régions précises du cerveau. Pour ses partisans, le développement du cerveau influerait sur la forme du crâne. Une capacité particulièrement développée (gaieté, causalité, bienveillance, etc.) inscrirait donc sa trace sur la « carte » qui apparaît sur le crâne phrénologique de Gall.

[17] Rapidement, Gall en vint à généraliser cette idée au point de déterminer une trentaine d'organes de ce type : organe de l'amour physique, de l'amitié, de l'esprit métaphysique, etc

[18] Korbinian Brodmann, nerophysiologiste allemand, suppose en 1909 que le cortex est subdivisé en 52 aires.

[19] Par stimulation électrique du cerveau, Wilder Penfield, neurochirurgien canadien, identifie les parties du cortex consacrées aux sensations et celles consacrées à la motricité (1937). Après avoir cartographié la répartition de ces zones, Penfield signe avec Theodore Brown Rasmussen The Cerebral Cortex of Man (1950) qui présente l'homoncule moteur et l'homoncule sensitif.

[20] Rajeev D. S. Raizada et Mark M. Kishiyama, Effects of socioeconomic status on brain development, and how cognitive neuroscience may contribute to levelling the playing field, Frontiers in Human Neuroscience, vol. 4, no 3, Lausanne, 2010.

[21] Pilyoung Kim (sous la dir. de), « Effects of childhood poverty and chronic stress on emotion regulatory brain function in adulthood » (PDF), Proceedings of the National Academy of Sciences of the United States of America, vol. 110, no 46, Washington, DC, 2013.

[22]http://www.allodocteurs.fr/actualite-sante-alzheimer-un-gene-retarderait-la-maladie-de-ans_13931.html

[23] Raymond Tallis, The Observer, Sunday 2 June 2013.

[24] Respectivement maître de conférences à l’université de Rouen, maître de conférences à l’université d’Aix-Marseille (Laboratoire de psychologie cognitive), professeur honoraire à l’Institut universitaire de France et à l’université de Grenoble, maître de conférences à l’université de Rouen.

14 réactions à cet article

Ajouter une réaction

Pour réagir, identifiez-vous avec votre login / mot de passe, en haut à droite de cette page

Si vous n'avez pas de login / mot de passe, vous devez vous inscrire ici.

FAIRE UN DON